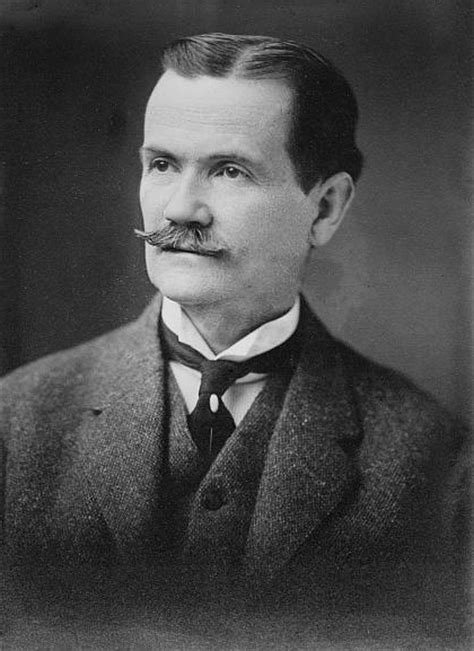

Ein Zitat von Andrew Ng

Ich denke, die erste Welle des Deep-Learning-Fortschritts waren hauptsächlich große Unternehmen mit einer Menge Daten, die sehr große neuronale Netze trainierten, oder? Wenn Sie also ein Spracherkennungssystem aufbauen möchten, trainieren Sie es anhand von 100.000 Stunden Daten.

Verwandte Zitate

Möchten Sie ein maschinelles Übersetzungssystem trainieren? Trainieren Sie es anhand einer Unmenge von Satzpaaren paralleler Korpora, und das führt zu vielen bahnbrechenden Ergebnissen. Ich sehe zunehmend Ergebnisse bei kleinen Datenmengen, bei denen man versuchen möchte, Ergebnisse zu erzielen, selbst wenn man 1.000 Bilder hat.

MapReduce ist zur Assemblersprache für die Big-Data-Verarbeitung geworden, und SnapReduce verwendet ausgefeilte Techniken, um SnapLogic-Datenintegrationspipelines in diese neue Big-Data-Zielsprache zu kompilieren. Unter Anwendung unseres gesamten Wissens über die beiden Welten der Integration und Hadoop haben wir unsere Technologie so entwickelt, dass sie direkt zu MapReduce passt und den Prozess der Konnektivität und Datenintegration im großen Maßstab nahtlos und einfach macht.

Wir erhalten mehr Daten über Menschen als jedes andere Datenunternehmen über Menschen, über irgendetwas – und das ist nicht einmal annähernd der Fall. Wir schauen uns an, was Sie wissen, was Sie nicht wissen und wie Sie am besten lernen. Der große Unterschied zwischen uns und anderen Big-Data-Unternehmen besteht darin, dass wir Ihre Daten aus keinem Grund an Dritte vermarkten.

Anwendungen des maschinellen Lernens und der künstlichen Intelligenz erweisen sich als besonders nützlich im Ozean, wo es sowohl so viele Daten – große Oberflächen, große Tiefen – als auch nicht genügend Daten gibt, dass es zu teuer und nicht unbedingt sinnvoll ist, Proben jeglicher Art zu sammeln überall.

Bei der ersten Welle des Internets ging es eigentlich um den Datentransport. Und wir haben uns keine großen Gedanken darüber gemacht, wie viel Strom wir verbrauchen, wie viel Kühlbedarf in den Rechenzentren besteht und wie groß die Fläche des Rechenzentrums ist. Das waren fast nachträgliche Gedanken.

Einer der Mythen über das Internet der Dinge besagt, dass Unternehmen über alle Daten verfügen, die sie benötigen, ihre eigentliche Herausforderung jedoch darin besteht, sie zu verstehen. Tatsächlich sind die Kosten für die Erhebung einiger Datenarten nach wie vor zu hoch, die Qualität der Daten ist nicht immer gut genug und es bleibt schwierig, mehrere Datenquellen zu integrieren.

Werbetreibende wollen nicht ignoriert werden und sind betrunken von unseren Daten, die Google und andere große Netzwerke in Wirklichkeit verkaufen. Die Anzeigen sind fast ein Nebenprodukt; Was Unternehmen wirklich wissen wollen, ist, welches Antitranspirant eine Frau zwischen 25 und 34 Jahren am ehesten kaufen wird, nachdem sie „House of Cards“ gesehen hat.

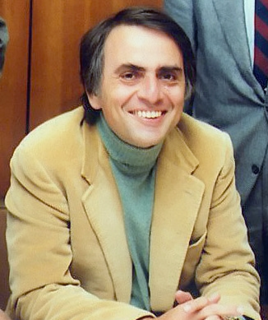

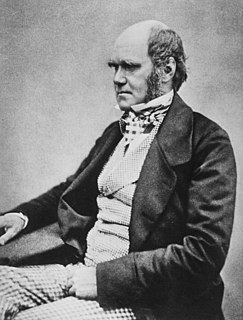

Wenn Wissenschaftler anderer Meinung sind, liegt das daran, dass wir nicht über ausreichende Daten verfügen. Dann können wir uns darauf einigen, welche Art von Daten wir erhalten; wir bekommen die Daten; und die Daten lösen das Problem. Entweder habe ich recht, oder du hast recht, oder wir liegen beide falsch. Und wir machen weiter. Eine solche Konfliktlösung gibt es weder in der Politik noch in der Religion.