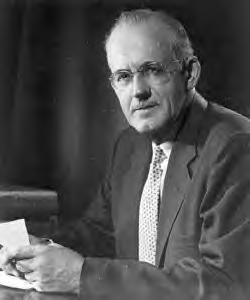

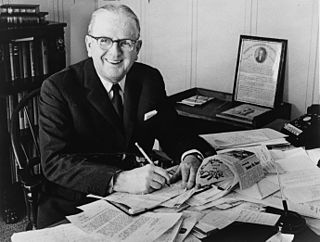

Ein Zitat von Charles Spurgeon

Die Hälfte unserer Ängste entsteht aus der Vernachlässigung der Bibel.

Themen zitieren

Verwandte Zitate

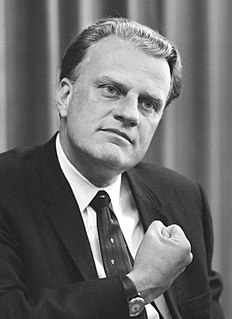

Wenn wir uns an die in der Bibel gelehrten Grundsätze halten, wird unser Land weiterhin gedeihen und gedeihen; Aber wenn wir und unsere Nachkommen ihre Anweisungen und Autorität missachten, kann niemand sagen, wie plötzlich eine Katastrophe uns überwältigen und all unseren Ruhm in tiefer Dunkelheit begraben könnte.

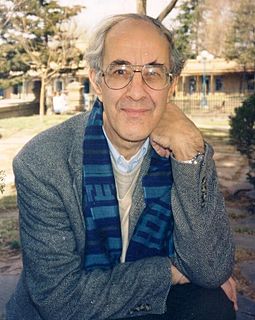

Du kannst nie alle deine Ängste loswerden. Einige sind notwendig und Teil des Lebens. Aber die meisten unserer Ängste sind illusorisch und basieren auf Risiken oder Bedrohungen, die nur in unserem Kopf existieren. Solche Ängste schränken ein und machen einen unglücklich. Das Gefühl, eine bestimmte Angst zu überwinden, ist ein Gefühl der Befreiung und Freiheit.

Ja, die Bibel sollte in unseren Schulen gelehrt werden, denn es ist notwendig, die Bibel zu verstehen, wenn wir unsere eigene Kultur und ihre Entstehung wirklich verstehen wollen. Die Bibel hat jeden Teil der westlichen Kultur beeinflusst, von unserer Kunst, Musik und Geschichte bis hin zu unserem Sinn für Fairness, Nächstenliebe und Geschäft.

Ich denke, eine der wichtigsten Veränderungen unserer Zeit war unsere Einstellung zur Angst. Jede Zivilisation verteidigt sich, indem sie Ängste fernhält und sagt: „Wir beschützen Sie vor Angst.“ Aber es erzeugt auch neue Ängste und im Laufe der Geschichte haben die Menschen die Art der Ängste, die sie beunruhigten, verändert.

Ängste, vor anderen schlecht auszusehen, etwas Falsches zu sagen, ausgelacht zu werden – all diese Ängste berauben uns der Hälfte unserer Fähigkeiten. Dies ist eines der Hauptprobleme der Schule. Der Lehrer versteht es, der den Schülern beibringen kann, ohne Angst vor dem Lehrer, ohne Angst vor Mitschülern und vor allem ohne Angst vor einem Fach zu lernen.

Ich plädiere sehr ernsthaft dafür, dass wir in unserem hektischen und ziemlich geschäftigen Leben von heute nicht den Einfluss verlieren, den unsere Vorfahren auf die Bibel hatten. Ich wünsche mir, dass das Bibelstudium in den weltlichen Hochschulen ebenso selbstverständlich ist wie im Priesterseminar. Kein gebildeter Mann kann es sich leisten, die Bibel nicht zu kennen, und kein ungebildeter Mann kann es sich leisten, die Bibel nicht zu kennen.