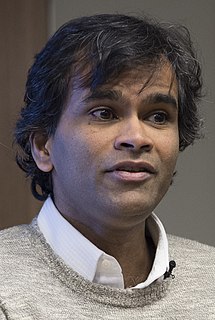

Ein Zitat von Martin Lindstrom

Während es bei Big Data vor allem um die Suche nach Zusammenhängen – und damit um die Durchführung schrittweiser Änderungen – geht, geht es bei Small Data vor allem um Kausalitäten – darum, die Gründe dafür zu verstehen.

Verwandte Zitate

Wir erhalten mehr Daten über Menschen als jedes andere Datenunternehmen über Menschen, über irgendetwas – und das ist nicht einmal annähernd der Fall. Wir schauen uns an, was Sie wissen, was Sie nicht wissen und wie Sie am besten lernen. Der große Unterschied zwischen uns und anderen Big-Data-Unternehmen besteht darin, dass wir Ihre Daten aus keinem Grund an Dritte vermarkten.

MapReduce ist zur Assemblersprache für die Big-Data-Verarbeitung geworden, und SnapReduce verwendet ausgefeilte Techniken, um SnapLogic-Datenintegrationspipelines in diese neue Big-Data-Zielsprache zu kompilieren. Unter Anwendung unseres gesamten Wissens über die beiden Welten der Integration und Hadoop haben wir unsere Technologie so entwickelt, dass sie direkt zu MapReduce passt und den Prozess der Konnektivität und Datenintegration im großen Maßstab nahtlos und einfach macht.

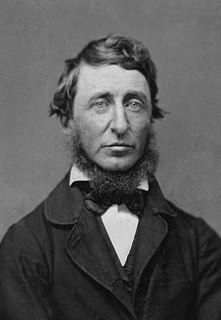

Daten sind keine Informationen. ... Informationen sind im Gegensatz zu Daten nützlich. Während zwischen Daten und Informationen eine Kluft besteht, klafft zwischen Information und Wissen ein weiter Ozean. Es sind nicht Informationen, die das Getriebe in unserem Gehirn drehen, sondern Ideen, Erfindungen und Inspiration. Wissen – nicht Information – setzt Verständnis voraus. Und jenseits des Wissens liegt das, was wir suchen sollten: Weisheit.

Schauen wir uns die Kreditvergabe an, wo Big Data für die Kreditwürdigkeit genutzt wird. Und es handelt sich übrigens nur um die Anreicherung von Kreditdaten, was wir auch tun. Es ist nichts Mystisches. Aber sie sind sehr gut darin, die Schmerzpunkte zu reduzieren. Sie können es schneller absichern, indem sie – ich nenne es einfach Big Data, weil es keinen besseren Begriff gibt: „Warum dauert es zwei Wochen? Warum schafft man es nicht in 15 Minuten?“

Der größte Fehler ist die übermäßige Abhängigkeit von Daten. Manager werden sagen, wenn keine Daten vorliegen, können sie keine Maßnahmen ergreifen. Es liegen jedoch nur Daten über die Vergangenheit vor. Wenn die Daten schlüssig sind, ist es zu spät, auf der Grundlage dieser Schlussfolgerungen Maßnahmen zu ergreifen.

Einer der Mythen über das Internet der Dinge besagt, dass Unternehmen über alle Daten verfügen, die sie benötigen, ihre eigentliche Herausforderung jedoch darin besteht, sie zu verstehen. Tatsächlich sind die Kosten für die Erhebung einiger Datenarten nach wie vor zu hoch, die Qualität der Daten ist nicht immer gut genug und es bleibt schwierig, mehrere Datenquellen zu integrieren.

Bei der ersten Welle des Internets ging es eigentlich um den Datentransport. Und wir haben uns keine großen Gedanken darüber gemacht, wie viel Strom wir verbrauchen, wie viel Kühlbedarf in den Rechenzentren besteht und wie groß die Fläche des Rechenzentrums ist. Das waren fast nachträgliche Gedanken.